Die neuen Funktionalitäten und Features der Forschungsbilddatenbank des IMAREAL

![]()

Abstract

Am Institut für Realienkunde des Mittelalters und der frühen Neuzeit in Krems (Universität Salzburg) wurde bereits in den 1970ern ein Langzeitprojekt initiiert, das neben den Daten zum Bildträger auch jene zu den Bildinhalten erschließt und speichert. Auf diese Weise konnten bisher über 1,2 Millionen Begriffe zu den dargestellten Bildelementen auf über 22.000 Datensätzen zu mittelalterlichen und frühneuzeitlichen visuellen Medien erfasst werden. Etwa die Hälfte der geografischen Standorte der aufgenommenen Werke liegt im heutigen Österreich; die zweite Hälfte verteilt sich auf angrenzende Regionen (Bayern, Südtirol, Tschechien, Slowakei, Slowenien, Ungarn) sowie Siebenbürgen (Rumänien). Der Datenbestand wird kontinuierlich erweitert. Die Bilddatenbank steht unter dem Namen REALonline seit 2002 im Internet kostenfrei zur Verfügung. Seither haben sich die Webtechnologien rasant weiterentwickelt und die Bedürfnisse der Nutzer_innen im Internet entsprechend verändert. Daher wurde in den vergangenen Jahren an einem Relaunch der Datenbank gearbeitet, der die Anforderungen für Ressourcen der Digital Humanities mit gängigen Features der Informationsverarbeitung und der interaktiven Nutzung im Internet verbindet. Im Beitrag werden vor allem die neuen Funktionen und Möglichkeiten des Frontends vorgestellt, die REALonline nach dieser grundlegenden Revision und Erweiterung für Wissenschafter_innen sowie für interessierte Nutzer_innen bietet.

Abstract (englisch)

Back in the 1970s, the Institute for Medieval and Early Modern Material Culture in Krems (University of Salzburg) initiated a long-term project that, alongside providing access to the data concerning the specific medium of an image, also accesses and stores data on its pictorial content. In this way, over 1.2 million terms relating to the pictorial elements shown have so far been recorded on over 22,000 data records concerning medieval and early modern visual media. Roughly one half of the works recorded are located in what is today Austria, with the other half spread around the neighbouring regions (Bavaria, South Tyrol, Czech Republic, Slovakia, Slovenia, Hungary) and Transylvania (Romania). The database is being continuously expanded and has been available for use free of charge on the Internet under the name REALonline since 2002. Since then, web technology has developed extremely quickly and the needs of users on the internet have changed accordingly. As a result, over the last few years work has been carried out on a relaunch of the database, linking the requirements for Digital Humanities resources with common features of information processing and interactive use on the internet. This article will present some of the new functions and possibilities offered to scholars and the interested public after the fundamental updating and expansion of REALonline.

Inhaltsverzeichnis

Das Institut für Realienkunde des Mittelalters und der frühen Neuzeit (IMAREAL) hat sich an der Entwicklung der heute unter Digital Humanities etablierten Teildisziplin der Geisteswissenschaften immer mit großem Interesse und aktivem Einsatz beteiligt. Anhand des Computereinsatzes bzw. der Anwendung von computergestützten Methoden in den verschiedenen Projekten ließen sich einige der wichtigsten Meilensteine in der Geschichte der Digital Humanities nachzeichnen. In diesem Beitrag möchten wir uns aber nicht mit dem Rückblick auf die Anfänge der Datenverarbeitung am IMAREAL beschäftigen, sondern mit gegenwärtigen Anforderungen an eine digital gestützte Wissenschaft. Um digital forschen zu können, bedarf es gewisser Voraussetzungen: Dazu zählen neben einer grundlegenden webbasierten Infrastruktur, die an Universitäten zur Standardausstattung gehört, sowohl spezielle Werkzeuge – wie z.B. Software für Bild-, Text-/Zahlen- oder Geodatenverarbeitung – als auch digital verfügbare Forschungsdaten. Das IMAREAL verfolgt seit jeher das Ziel, die in den Institutsprojekten erhobenen Forschungsdaten und Daten, die im Rahmen von Quellenerschließungsprojekten gewonnen werden, nicht nur für die „eigenen“ wissenschaftlichen Ergebnisse zu verwerten, sondern diese auch der scientific community sowie der interessierten Öffentlichkeit – möglichst gut aufbereitet und kostenfrei – online zugänglich zu machen. Im Rahmen dieser Digitalstrategie, zu der schließlich auch die Umstellung der Analogpublikation Medium Aevum Quotidianum (MAQ) in das Online-Journal MEMO gehört, konnten bisher sieben Forschungsdatenbanken online gestellt werden.

Was ist REALonline?

REALonline wurde am IMAREAL bereits in den 1970er Jahren entwickelt, um visuelle Medien des Mittelalters und der frühen Neuzeit auf breiter Basis in die interdisziplinäre Erforschung der materiellen Kultur miteinzubeziehen. Das Langzeitprojekt hat folgende Zielsetzungen:

- die Grundlagen für die Erforschung von dargestellten Objekten und ihrer Bedeutung im Bilddiskurs sowie für interdisziplinäre Untersuchungen zur materiellen Kultur zu schaffen und

- die Dokumentation und Sicherung des visuellen Kulturerbes voranzutreiben.

Dazu müssen die auf Bildern dargestellten Dinge und ihre Kontexte systematisch erschlossen und diese erhobenen Informationen in einer Datenbank verwaltet und abfragbar gemacht werden. Diese Informationen bezeichnet man in den Digital Humanities auch als Annotationen, weil sie sich auf bestimmte Aspekte eines Datensatzes beziehen – in unserem Fall z.B. auf einen dargestellten Tisch – und grenzt sie damit gegen Metadaten ab, die etwas über einen gesamten Datensatz, z.B. ein Kunstwerk, aussagen. Um diesen Unterschied allgemein verständlich transportieren zu können, differenzieren wir hier auch zwischen ‚Werken‘ (Informationen zum Bildträger) und ‚Beschreibungen‘ (Informationen zu dargestellten Bildelementen). In den meisten Bilddatenbanken von Kultur- und Wissenschaftseinrichtungen sind nur Metadaten (Künstler_innen, Datierung, Maße, etc.) zu einem Werk enthalten. Das liegt vor allem daran, dass semantische Daten nach wie vor überwiegend manuell erfasst werden müssen. Grund dafür ist wiederum ein Phänomen, das man gemeinhin als Semantic Gap bezeichnet. Digitale Repräsentationen aller Arten von Medien (Texte, Bilder, Artefakte etc.) sind für Computer Abfolgen von Bits, eine Matrix von Pixeln oder Sequenzen von einzelnen Zeichen. Um semantische Auswertungen machen zu können, bedarf es deshalb zunächst einer Kodierung, die relevante semantische Sinnstrukturen so festhält, dass sie mit dem Computer verarbeitet werden können. Automatisierungen von Prozessen, die Vorarbeiten dafür darstellen, sind je nach Medium unterschiedlich weit entwickelt. Bei Bildern ist es etwa im Unterschied zu gedruckten Texten nicht trivial, einzelne Bildelemente automatisiert zu segmentieren und einem möglichen übergeordneten begrifflichen Konzept zuzuordnen.

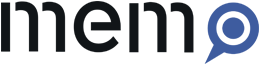

Aufgrund des hohen Kosten- und Zeitaufwands, der mit einer manuellen Erhebung von semantischen Daten zu Aspekten eines Bildes verbunden ist, stehen diese nur in einem sehr geringen Ausmaß in Bilddatenbanken zur Verfügung, die historische Bildmedien erfassen. Überwiegend sind sie bisher in Metadaten enthalten, die Überschneidungen zum Bereich der Annotationen darstellen, wie z.B. im Bildthema oder innerhalb von zum Datensatz vergebenen Schlagwörtern. Wenn umfangreiche und detaillierte Informationen zu den Bildinhalten erfasst werden, handelt es sich überwiegend um Projekte, die dies – wie es auch bei REALonline der Fall ist – aufgrund eines konkreten Forschungsinteresses tun, die auf eine bessere Nutzung digitaler Anwendungen im Kunst- und Kulturvermittlungsbereich abzielen, oder bei welchen unter Einbeziehung von Crowdsourcing Schlagwörter zum Bildinhalt generiert werden. Die Unterschiede in Bilddatenbanken zu historischen visuellen Medien hinsichtlich der Erfassung von semantischen Informationen seien an einem Beispiel illustriert, nämlich am Holzschnitt mit dem letzten Abendmahl aus der so genannten „Kleinen Passion“ von Albrecht Dürer, der um 1508/09 entstanden ist. Nachdem es sich um ein vervielfältigbares Medium handelt, sind bereits die erhaltenen Originale selbst in verschiedenen Sammlungen und damit auch in den digitalen Plattformen derselben vertreten. Aufgrund der Bekanntheit dieses Werks und seines Künstlers finden sich aber darüber hinaus Datensätze zu diesem Holzschnitt in Bilddatenbanken anderer Kultur- und Wissenschaftseinrichtungen. Damit kann man anhand dieses Beispiels vergleichen, welche und wie viele dargestellte Elemente erfasst werden (Tabelle 1).

- Tabelle 1: Erfasste dargestellte Elemente in lizenzfrei zugänglichen Bilddatenbanken zum Holzschnitt „Letztes Abendmahl“, sog. Kleine Passion, Albrecht Dürer, um 1508/09. Alle angegebenen Metadaten (Beschreibung, Schlagwörter, etc.) und Annotationen wurden berücksichtigt.

Die in REALonline erfassten semantischen Daten sind aber nicht nur angesichts ihrer Quantität eine wichtige Grundlage für Forschungen zu mittelalterlichen und frühneuzeitlichen visuellen Medien, sondern vor allem aufgrund des zugrunde gelegten Datenmodells. Im Unterschied zu anderen Bilddatenbanken werden diese Daten nämlich nicht als freier Fließtext oder als Aneinanderreihung von Begriffen gespeichert. Für jeden Datensatz kann in REALonline eine beliebige Anzahl an Entitäten erfasst werden, die einem Set an festgelegten Entitätstypen (Szenen, Figuren, Körperteile, Objekte, Kleidungsstücke, Handlungen, historische Orte, Settings etc.) zugeordnet sind. Die Verbindungen zwischen den Entitäten sind so modelliert, dass auch Informationen zu Bestandteilen (z.B. „hat Teil“) oder Bezüge („enthält“, „hat Bezug zu“, „hält“, „trägt“ etc.) abgebildet werden können. Zudem können nähere Bestimmungen zu den einzelnen Entitäten festgehalten werden: Bei Personen sind das Informationen zu den Kategorien „Name“, „Status / Beruf / Lebensalter“, „Geschlecht“ und „Gestik / Körperhaltung“. Bei Objekten, Tieren, Pflanzen etc. werden „Name“, „Farbe“, „Material“ und „Form“ erfasst. Sowohl den Informationen zu den Annotationen als auch zu den Metadaten sind umfangreiche und detaillierte Thesauri zugrunde gelegt, die eine standardisierte Aufnahme erlauben. Die Entwicklung der Thesauri erfolgte aus den konkreten Anforderungen nach einer praktikablen thematischen Strukturierung des komplexen Vokabulars, das auf die Anschlussfähigkeit mit vorliegenden Ontologien aus benachbarten Projekten und auf Anforderungen im Semantic Web hin überarbeitet werden kann. Im Zuge des Relaunchs (s.u.) wurden auch Referenzen zu Normdaten, wie dem Klassifikationssystem ICONCLASS oder der Gemeinsamen Normdatei (GND) eingearbeitet.

REALonline umfasst derzeit über 22.000 Datensätze, bestehend aus über 28.500 digitalisierten fotografischen Aufnahmen (bzw. seit einigen Jahren den Digitalfotos), den Metadaten zu den erfassten Kunstwerken und Artefakten und den Annotationen. Bei der Auswahl und Aufnahme werden folgende Bildträger und visuelle Medien berücksichtigt: Tafelmalerei, Wandmalerei, illuminierte Handschriften, Zeichnungen und frühe Druckgrafik, darüber hinaus auch bildtragende materielle Objekte. Einbezogen werden Bildquellen vom 11. bis zum 18. Jahrhundert, die Mehrzahl der erfassten Werke datiert in den Zeitraum zwischen dem 14. und dem 16. Jahrhundert. Fotografiert wurde und wird schwerpunktmäßig in den „klassischen“ Kulturerbe-Institutionen, wie Museen, Kirchen und Klöstern, öffentlichen Sammlungen und Bibliotheken, weiters in Burgen und Profangebäuden sowie vereinzelt auch in Privateinrichtungen. Die geografischen Standorte der aufgenommenen Werke liegen ca. zur einen Hälfte im heutigen Österreich; die zweite Hälfte verteilt sich auf angrenzende Regionen (Bayern, Südtirol, Tschechien, Slowakei, Slowenien, Ungarn) sowie Siebenbürgen (Rumänien). Der Datenbestand wird kontinuierlich erweitert.

REALonline enhanced. Die neue Version der Bilddatenbank

- Abb. 1: Screenshot der Startseite von REALonline

Die Bilddatenbank REALonline ist die wichtigste und umfangreichste digitale Ressource am IMAREAL. Sie steht seit 2002 kostenfrei im Internet zur Verfügung und wurde in den letzten drei Jahren einem umfassenden Relaunch unterzogen; seit Mai 2017 ist sie in aktuellem Design und um viele Suchfunktionen erweitert unter der neuen URL https://realonline.imareal.sbg.ac.at erreichbar. Die Nutzer_innen können in die Bildwelten des Mittelalters und der frühen Neuzeit eintauchen, dort gezielt nach Bildern und darauf dargestellten Details suchen, sich über Forschungsfragen an die visuellen Medien annähern oder einfach nur stöbern. Einen ersten Eindruck, welche neuen Möglichkeiten die Bilddatenbank bietet, möchte der Imagefilm zur Datenbank vermitteln. Die Kommunikation zwischen Nutzer_innen und dem Computer bzw. den digitalen Tools läuft über das grafische User-Interface (GUI), das gleichzeitig als mächtige Schnittstelle für die Präsentation digitaler Informationen und als Steuerung komplexer Prozesse dahinter dient. Wie bei den meisten gängigen Bilddatenbanken ist das GUI in den Internetbrowser integriert, sodass keine weiteren Softwarepakete mehr installiert werden müssen. Das Frontend von REALonline läuft mit WordPress, einem open source Web-Publishing-System, das sich in den letzten Jahren großer Verbreitung erfreut.

Im Folgenden möchten wir darlegen, welche Überlegungen bei der Entwicklung des neuen User-Interfaces leitend waren und welche Komponenten zum Einsatz kommen.

Bilder betrachten: Zoom View

Digitale Bilder bestehen aus Pixeln, die die Farbinformationen tragen, unabhängig davon, ob es sich um Aufnahmen, die mit der Digitalkamera gemacht wurden, oder um digitalisierte Fotos handelt. Je höher die Bildauflösung in dots per inch (dpi) ist, umso besser ist die Bildqualität in Schärfe und Detail. Selbstverständlich hängt die Anzeigequalität ganz eng mit der Bildschirmauflösung und dem Farbraum, der wiederum von der Grafikleistung des Computers abhängt, zusammen. Nur kalibrierbare Bildschirme gewährleisten eine möglichst originalgetreue Wiedergabe der Farbinformationen. Wer Bilddatenbanken online zur Verfügung stellt, hat keinen Einfluss auf die Ausstattungen, die Nutzer_innen verwenden. Erwartet wird heute, dass Bilder am Monitor stufenlos und komfortabel zoombar sind, sodass man auch winzige Details erkennen kann. Angezeigt wird bei den meisten digitalen Bildrepositorien zuerst eine vorab zusammen gestellte oder mittels Suchanfrage gefilterte Auswahl von Vorschaubildern. Klickt man auf eines, öffnet sich der zugehörige Datensatz und ein größeres Bild am Monitor. Die rasche Übertragung wird technisch durch das Zusammenspiel zwischen Bildserver und Viewer realisiert. Bei REALonline werden die Bilddateien durch den Bildserver IIPImage als Bildpyramiden in mehreren Auflösungsstufen vorberechnet und bei der Anfrage – mit dezenten Wasserzeichen versehen – an den OpenSeadragon Viewer im Frontend ausgeliefert. Während wir die Bilder der Vorgängerversion von REALonline nur in einer Vergrößerungsstufe anzeigen konnten, bietet der für die neue Version gewählte Viewer den großen Vorteil, dass die Bilder nun auch stufenlos zoombar sind. Der Bildbestand von REALonline umfasst derzeit über 28.500 digitale Bilddateien. In der Vorbereitung zum Relaunch haben wir ca. 16.000 Aufnahmen, die noch auf Mittelformatdia entwickelt wurden und schon in den späten 1990er Jahren entsprechend den damaligen Möglichkeiten der Speicherung digitalisiert wurden, einzeln mit Bildbearbeitungsprogrammen nachbearbeitet und im TIFF-Format gespeichert, um Informationsverluste, die durch die Digitalisierung bedingt waren, in Grenzen zu halten. Seit der Umstellung auf die Digitalfotografie liegen die Bilder in einer Pixeldichte vor, die im Rahmen der digitalen Bildbearbeitung auf eine für die Übertragung im Internet geeignete Bildgröße reduziert wird.

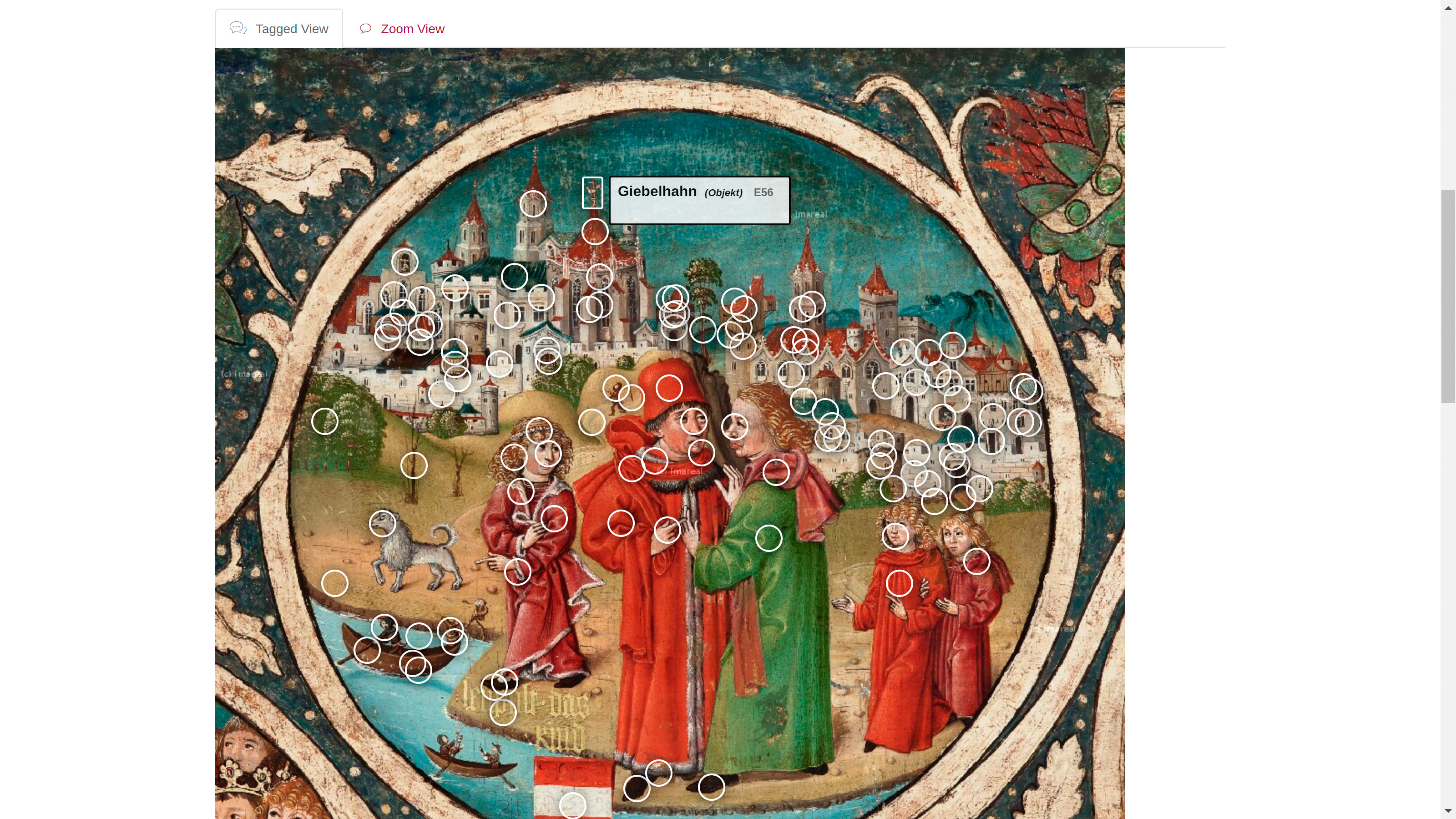

Tagged View – Das Annotieren

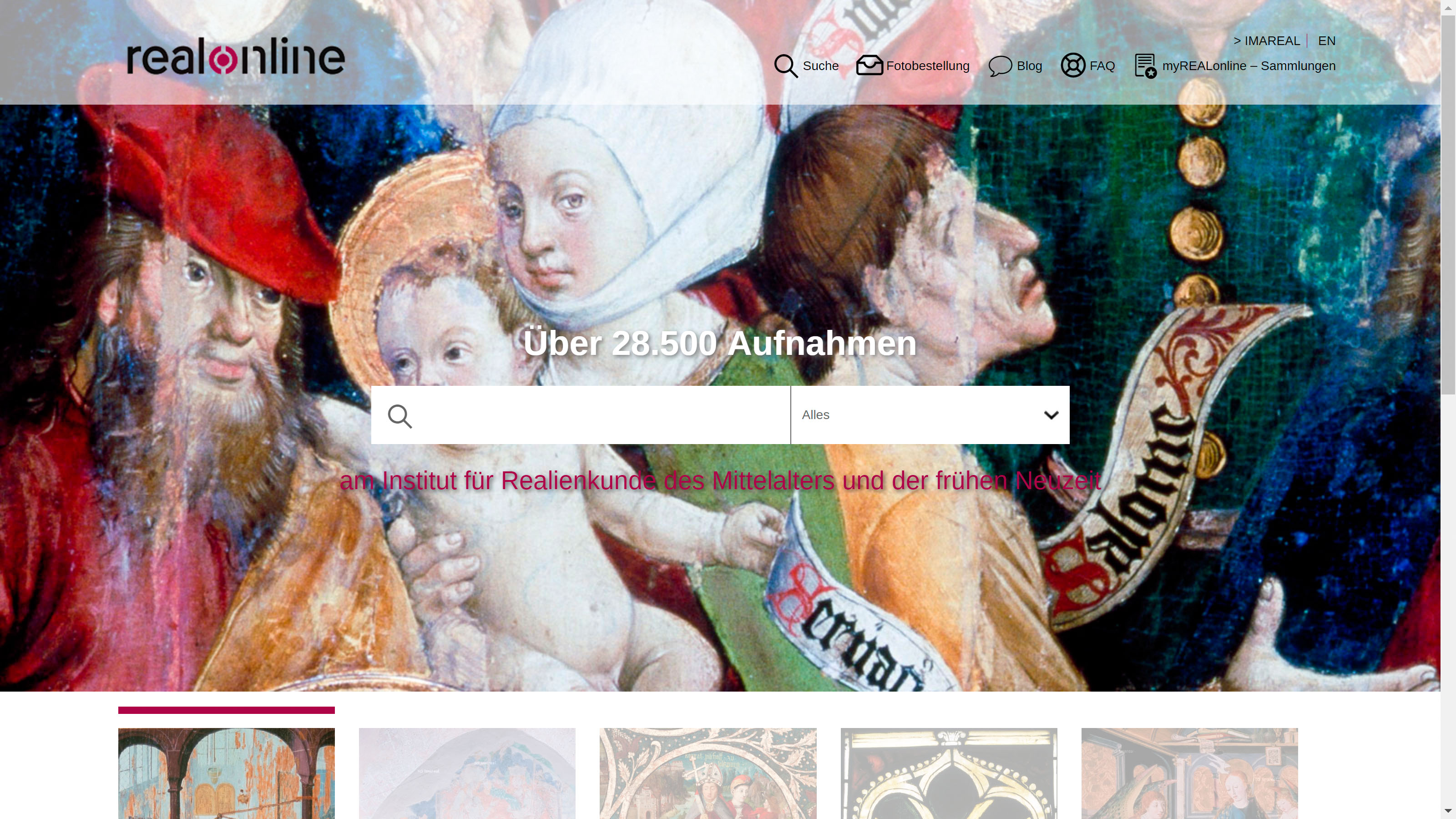

Durch die Integration des Image Viewers im neuen Interface können die Bilder nun wesentlich besser als bisher am Monitor betrachtet werden. Zusätzlich wollten wir durch die gezielte Verbindung von Bildausschnitten mit textuellen Daten noch einen Schritt weiter gehen. Dieses Vorgehen bezeichnet man als Annotieren oder Tagging. Bild-Text-Annotationen sind mittlerweile besonders im Bereich der digitalen Karten fest etabliert. Im engeren historisch-kulturwissenschaftlichen Feld ist diese Methode der Informationsanreicherung an einem umfangreichen Bestand von Bildern und Druckgraphiken aus der vorindustriellen Zeit des Museums Boijmans van Beuningen in Rotterdam in der Forschungsdatenbank ALMA realisiert worden; annotiert wurden die auf den Bildern dargestellten Objekte.

- Abb. 2: Screenshot des Datensatzes zu Jan van Eycks “Drei Marien am Grab” in der Online-Sammlung des Museums Boijmans van Beuningen. Ausgewählt ist die “Discover Alma”-Ansicht.

Mittlerweile stehen einige digitale Annotationstools frei zur Verfügung mit denen die Koordinaten von Bildausschnitten erzeugt und mit den Textannotationen verknüpft werden können. Im Zuge des Relaunches wurde auch das Backend von REALonline komplett neu programmiert. Dabei kommt der Image Viewer zum Einsatz, um die Bilder bei der Datenerfassung – bei Bedarf auch auf einem zweiten Monitor – anzuzeigen. Die Tagging-Funktionalität ist in den Backend-Editor integriert.

- Abb. 3: Screenshot vom Backend-Editor von REALonline mit Annotationstool.

Jedes Bilddetail, das in der Beschreibung als Gegenstand, Person, Körperteil, Kleidung, Handlung usw. textuell ausgezeichnet wurde, muss am Bild identifiziert und markiert werden. So können etwa dargestellte Personen oder Gebäude anhand eines Rechtecks oder eines Punkts kenntlich gemacht und die Koordinaten dieser geometrischen Formen gespeichert werden. Auf das exakte „Nachzeichnen“ entlang der Konturen von dargestellten Gegenständen oder Personen durch Polygone muss aufgrund des hohen Arbeitsaufwandes vorerst verzichtet werden. Das Taggen von Bildausschnitten geschieht ausschließlich manuell und verlangt eine hohe fachliche Kompetenz. Mit den personellen Ressourcen des Instituts können derzeit nur kleinere Bestände bearbeitet werden. Zusätzlich werden Kooperationen mit Projekten angestrebt, die mit REALonline arbeiten und in deren Umfeld sich auch potentielle Bearbeiter_innen befinden, die das Interesse und die Expertise zum „Taggen“ der im Rahmen ihrer eigenen Forschungen genutzten Bilder mitbringen. Auf diesem Weg konnte im letzten Jahr der Babenberger-Stammbaum bearbeitet werden. Im Frontend wird in der Einzelbildanzeige bei den bereits bearbeiteten Bildern ein Tab für die „Tagged View“ angezeigt, über das man auf das annotierte Bild umschalten kann. Auf das digitale Bild wird ein Layer mit Kreisen gelegt, die beim „mouseover“ über die markierten Bildbereiche den verknüpften Textbegriff anzeigen, also wenn der/die Nutzer_in mit dem Mauszeiger darüber fährt.

- Abb. 4: Screenshot von REALonline 000353 – „Tagged View“.

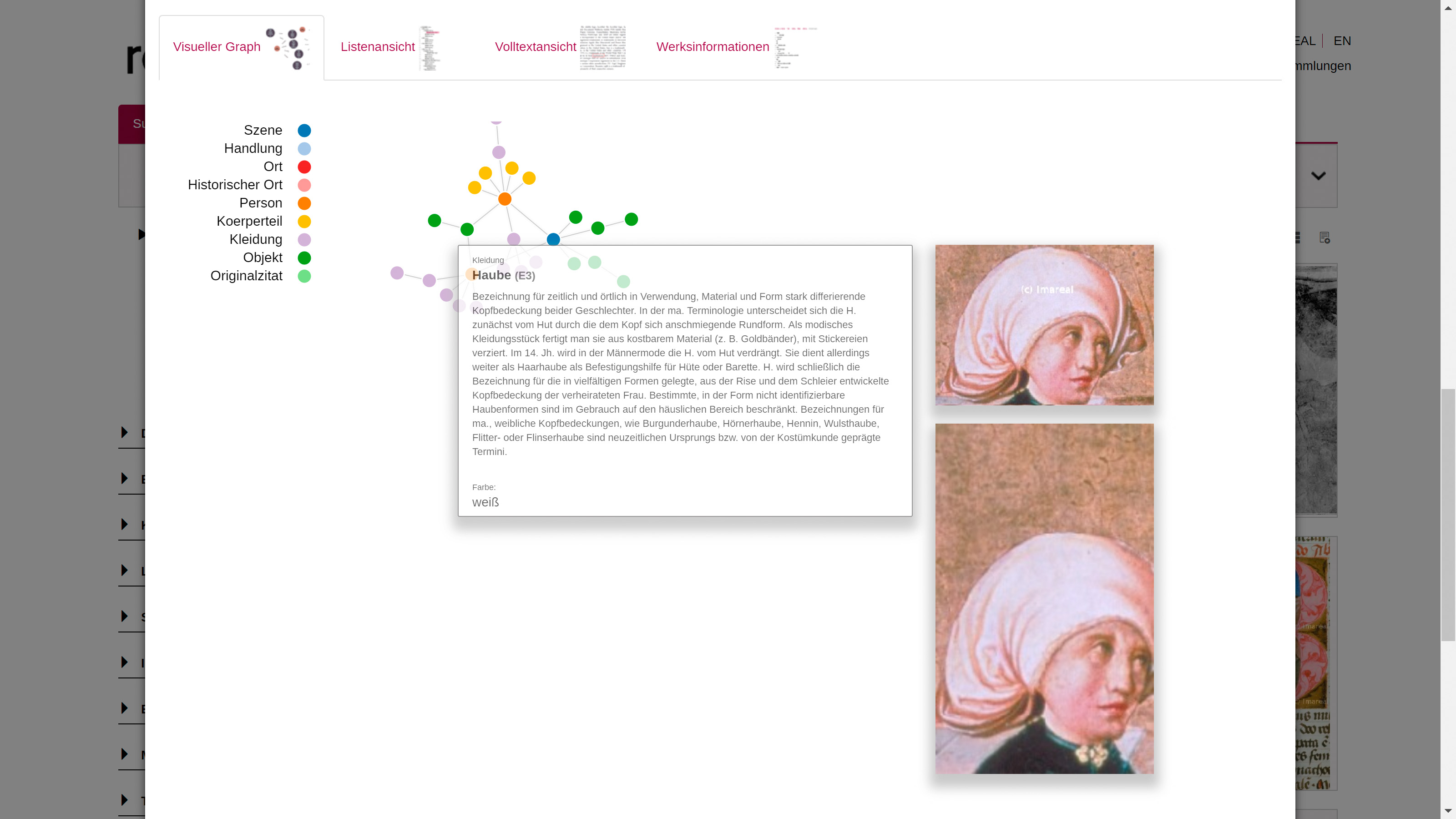

Ansichtssache: Graph-, Listen-, Volltext- und Werksdaten-Anzeige

Anhand der gespeicherten Annotations-Koordinaten kommen auch Bildausschnitte bei zwei der weiteren Möglichkeiten, sich die Daten in REALonline anzusehen, zum Einsatz: bei der Graph- und der Listenansicht. Diese stellen zwei unterschiedliche Sichtweisen auf die textuellen Begriffe dar, die zu jedem einzelnen Werk erfasst werden. Neben den Daten zum Kunstwerk bzw. Bildträger wird das Dargestellte in verbalen Begriffen in der Datenbank gespeichert. Diese sehr detaillierten und umfangreichen Beschreibungsdaten (über 1,2 Millionen Begriffe) wurden ursprünglich hierarchisch strukturiert und beim Relaunch in eine Graphenmodellierung übersetzt. In der Graph-Ansicht werden die Informationen zu jedem Einzelbild bzw. zu jeder Bildszene als Graph visualisiert. Die farblich unterscheidbaren Knoten visualisieren die Entitäten unterschiedlicher Kategorien (Person, Kleidung, Handlung etc.), die in der Bildbeschreibung verwendet werden. Eine Legende gibt darüber Auskunft, welche Farbe für welche Kategorie steht. Die Verbindungen zwischen den einzelnen Knoten – in der Fachterminologie als Kanten bezeichnet – repräsentieren die Beziehungen, die zwischen zwei Entitäten bestehen. Damit wird die Struktur und Komplexität der zu jeder einzelnen Bildszene gespeicherten Informationen auf einen Blick sichtbar. Durch das „mouseover“ auf die Knoten und Kanten können wiederum die Detailinformationen und – wenn vorhanden – auch die Bildausschnitte aufgerufen werden. Angezeigt werden darüber hinaus (mehr oder weniger ausführliche) Informationen aus dem Kleidungslexikon, Daten zu Personen sowie Verweise auf Normdaten oder Klassifikationssystemen wie GND– oder ICONCLASS-Notationen; an den Verlinkungen auf letztere wird laufend weitergearbeitet.

- Abb. 5: Screenshot von REALonline 001324 – Graphenansicht mit Lexikoninformation und Bildausschnitt.

Diese Daten können auch bei der Listenansicht per Klick auf die jeweiligen Begriffe zugeschaltet werden. Die Listenansicht orientiert sich in der Ausgabe am Monitor an der Vorgängerversion von REALonline und hat den Vorteil, dass hier immer alle zu einem Bild erfassten Personen-, Objekt- und Kleidungsnamen aufgelistet werden. Die scrollbare Anzeige passt sich bei umfangreichen Beschreibungen in der Länge nach unten an. Eine strukturierte Zusammenschau von Werks- und Beschreibungsdaten bietet die Volltextansicht. Dem liegt der Ansatz zugrunde, dass die Nutzer_innen alle zu einem Werk erfassten Daten über das Interface zur Verfügung gestellt bekommen sollen, auch wenn das mitunter eine sehr reiche Fülle an Informationen bedeutet. Zusätzlich können im Tab „Werksinformationen“ noch gezielt Informationen zum Datensatz, zu Themen, Herstellung, Bildträger und der Lokalisierung aufgerufen, oder alle diese Daten gesammelt in einer Aufstellung angezeigt werden.

Damit möchten wir hier den Teil abschließen, in dem zu zeigen versucht wurde, welche Überlegungen bei der Gestaltung der Bild- und Textausgabe am Monitor maßgeblich waren und uns dem zweiten großen Block zuwenden, der uns bei der Neugestaltung der Bilddatenbank intensiv beschäftigt hat: Wie lassen sich die vorhandenen Informationen gezielt abfragen?

Suchen und Finden

Web Information Retrieval (oder Web Mining) ist eine relativ junge interdisziplinäre Forschungsrichtung, in der Kognitionsforscher_innen der Psychologie und Neurologie gemeinsam mit Informatiker_innen daran arbeiten, zu ergründen, wie wir denken und wie wir uns erinnern. Suchmaschinenanbieter arbeiten an intelligenten Suchsystemen und betreiben eigene Forschungsabteilungen, die sich mit dem Onlineverhalten von Nutzer_innen befassen. Bei der Websuche geben die großen kommerziellen Player die Richtung vor: Google hat beispielsweise das Volltextsuchfeld etabliert und die Page-Ranking-Softwarealgorithmen entwickelt, um aus Milliarden von Internetseiten in Sekundenschnelle personalisierte Suchergebnisse aufzulisten; in vielen Online-Shops und Bibliothekskatalogen kommt die Facettensuche zum Einsatz, um große Informationsmengen gezielt zu filtern. Diverse touristische Preisvergleichsportale arbeiten unter anderem mit Geoinformationen, um den Nutzer_innen den Weg zum Hotel oder Restaurant ihrer Wahl zu erleichtern. Im Zuge der Entwicklung des User-Interfaces haben wir die derzeit gängigen Suchfeatures intensiv diskutiert, auf ihre Brauchbarkeit überprüft und schließlich über „use cases“ für die Informationssuche in REALonline adaptiert. Bei der Umsetzung sind wir von zwei Szenarien ausgegangen:

- Die Besucher_innen von REALonline suchen nach Bildern.

- Die Nutzer_innen analysieren die verfügbaren Daten im Rahmen ihrer Forschungsfragen.

Szenario A: Die Suche nach Bildern

Wie die Websuche generell, funktioniert auch die Suche nach digitalen Bildern schwerpunktmäßig immer noch über Textzeichen. REALonline bietet dazu einen umfassenden Pool an textuellen Begriffen, die zur Suche herangezogen werden können. Weil erheblich mehr Informationen zu den dargestellten Elementen erfasst werden, die auch als Suchkriterien verwendet werden können, gestaltet sich die Bildsuche in REALonline anders als in vielen anderen Bilddatenbanken aus dem Bereich der Kultur- und Wissenschaftseinrichtungen.

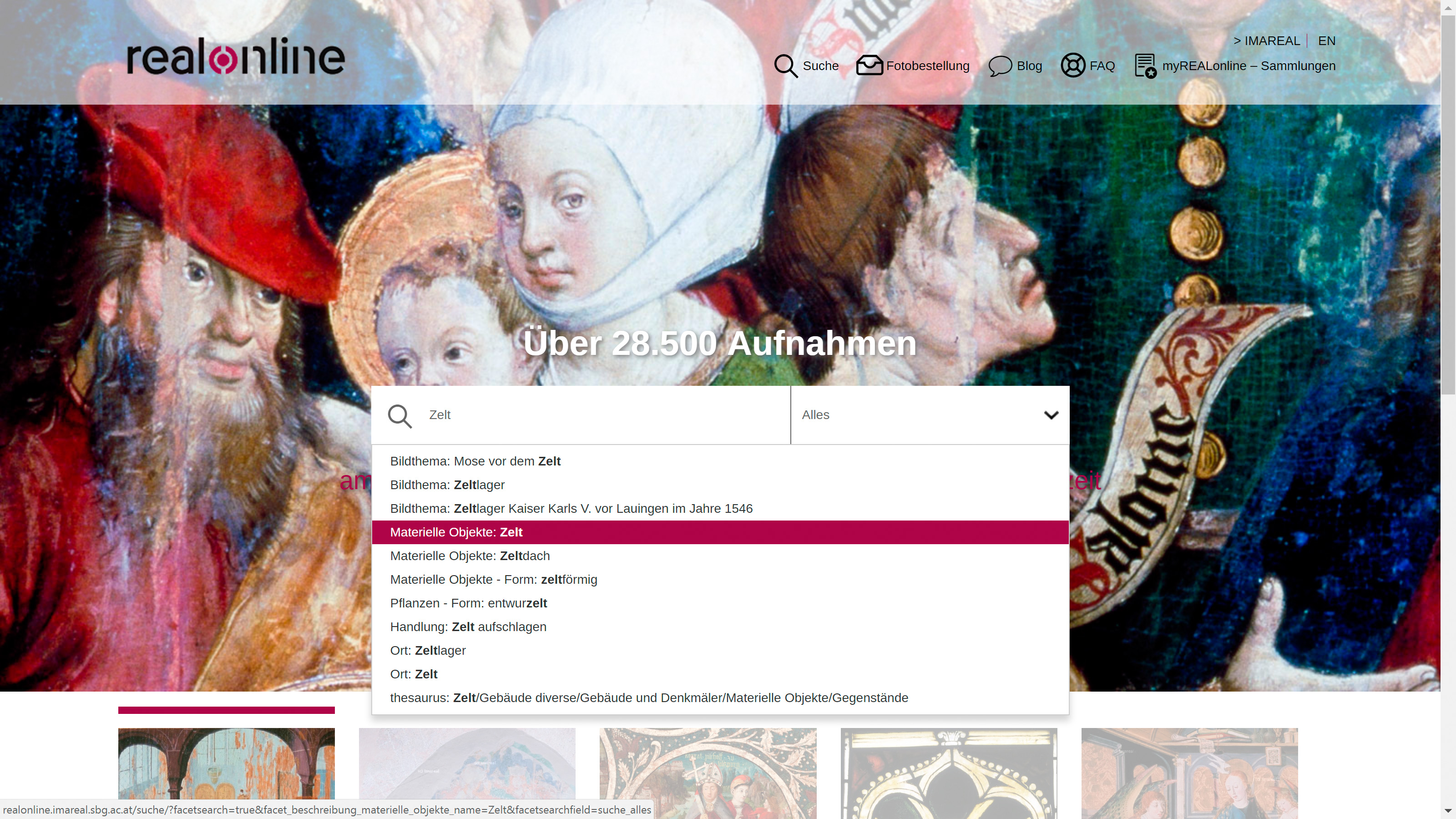

Unter den zahlreichen neuen Suchfunktionalitäten im GUI von REALonline ist als erstes das Volltextsuchfeld zu nennen: es dient der Schnellsuche und ist für Nutzer_innen interessant, die schon recht genau wissen, was sie suchen (z.B. eine ganz bestimmte Archivnummer) oder solche, die sich noch nicht so gut auskennen und im ersten Schritt über Suchbegriffe herantasten möchten, von denen sie erwarten, dass sie zu Ergebnissen führen. Die eingegebene Zeichenkette kann Teil eines gesuchten Begriffes sein; die Volltextsuche arbeitet mit den Bool’schen Operatoren AND, (inklusives) OR und NOT, mehrere Wörter werden automatisch mit (inklusivem) OR verknüpft. In der Defaulteinstellung wird über den gesamten Textbestand gesucht, es kann wahlweise auf die Werks- oder Beschreibungsdaten eingeschränkt werden. Um den Unterschied an einem Beispiel zu erklären: Tippt man „Katze“ in das Volltextsuchfeld erhält man mit der Einstellung „Alles“ 33 Treffer, mit der Einstellung „Beschreibungen“ werden 32 Ergebnisse angezeigt und bei „Werke“ nur zehn. Diese zehn Treffer geben Bilder aus, in denen das Wort „Katze“ in den Metadaten über die Bilder vorkommt, beispielsweise im Bildthema oder auch als Teil der Ensemblebezeichnung (z.B. „Grabstein des Rudolf von Katzenstein“). Bei der Auswahl „Beschreibung“ kommen alle Bilder in die Ergebnisanzeige, bei denen eine Katze auf dem Bild dargestellt und diese im Zuge der Datenerfassung auch textuell ausgezeichnet worden ist. Weil er eine Katze im Wappen führte und dieses auf seinem Grabmal wiedergegeben ist, wird der Grabstein des Rudolf von Katzenstein auch dann gefunden, wenn man nur unter den Beschreibungen nach einer Katze sucht. Die Volltextsuche ermöglicht eine schnelle Abfrage der insgesamt ca. 2,5 Millionen Begriffe. Für die gezielte Informationssuche ist sie aber oft zu ineffizient, weil sie entweder nicht die richtigen oder zu viele Ergebnisse auswirft. Mithilfe einer Vorschlagliste, die sich im Volltextsuchfeld der Startseite nach der Eingabe von drei Zeichen aufklappt, kann die Suche schon auf dieser Ebene in eine Richtung gelenkt werden.

- Abb. 6: Screenshot der Startseite von REALonline: Volltextsuche mit dem Suchterm „Zelt“ und den automatisch generierten Vorschlägen.

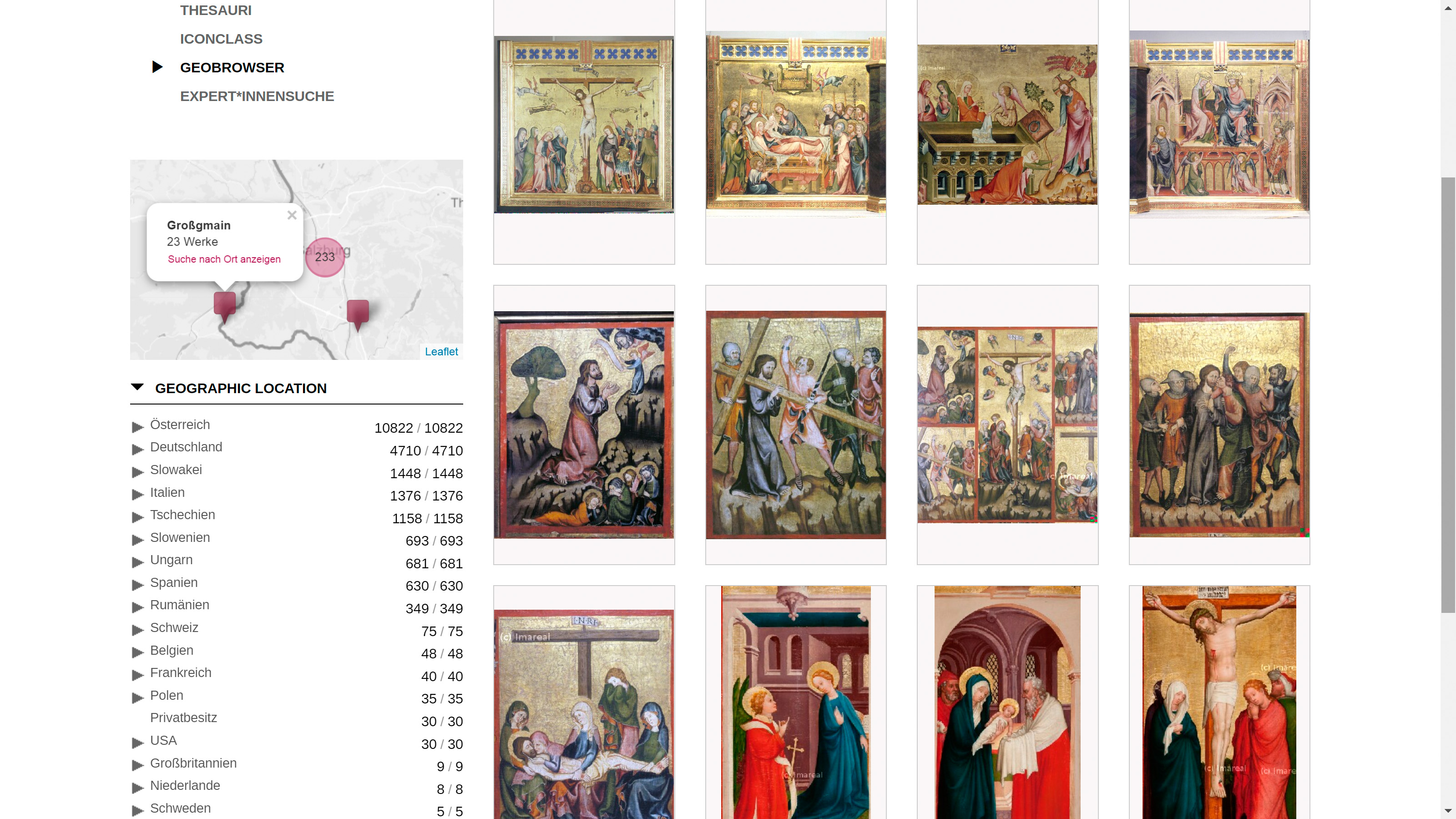

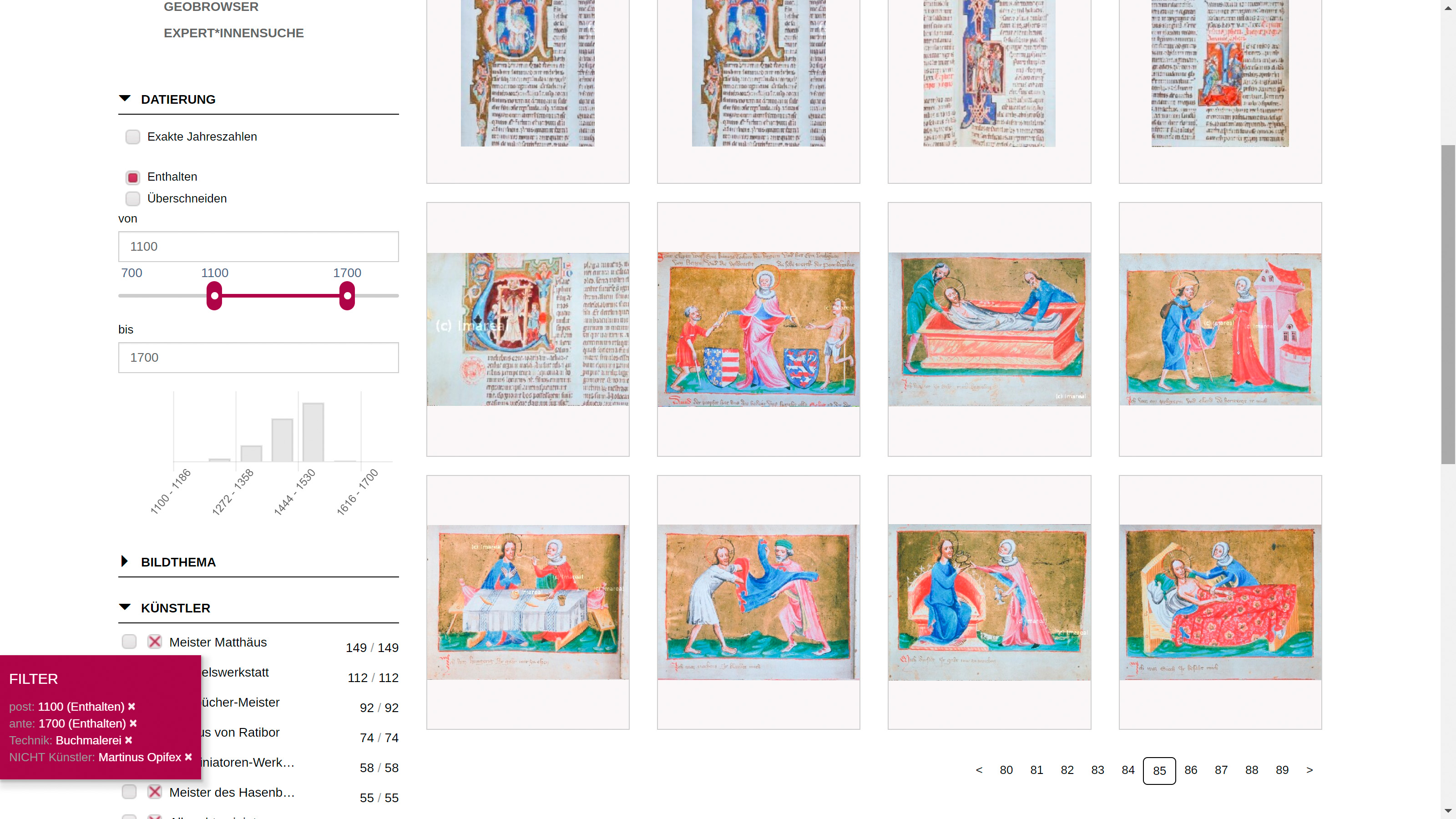

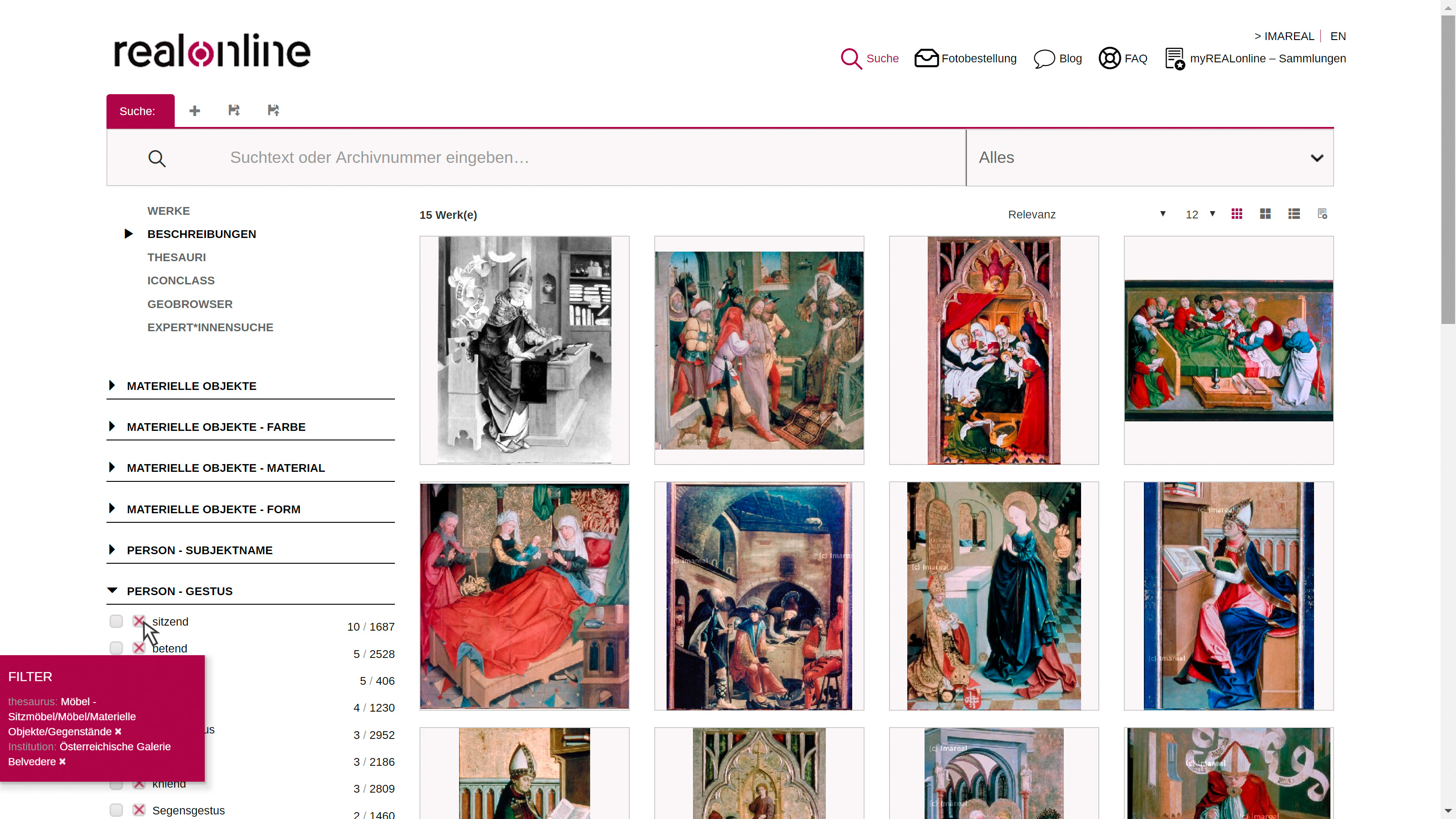

Um große Informationsmengen gezielt zu filtern und komplexe Abfragen durchzuführen, wurde die Facettensuche implementiert. Bevor wir an einem Beispiel zeigen, wie sie funktioniert und was damit möglich ist, möchten wir einen Schnelldurchgang durch die Suchfacetten (auf der linken Seite der Monitoranzeige) voranstellen: Aufgrund der Fülle an Einschränkungsmöglichkeiten werden den Nutzer_innen unterschiedliche Suchfilter-Typen (Werke, Beschreibungen, Thesauri, Iconclass, Geobrowser) angeboten, die über ein Menü anwählbar sind. Alle Kategorien dieser Suchfilter-Typen können auch in Kombination verwendet werden. Zur Auswahl stehen bei den Werksfacetten im Wesentlichen jene Metadaten, wie sie auch in anderen Datenbanken von Kulturerbe-Institutionen angeboten werden (Bildthema, Datierung, Künstler, Standort, Material usw.). Bei den Beschreibungsfacetten bieten wir Materielle Objekte, Person, Körper, Kleidung, Tiere, Pflanzen, Sonstiges, Handlung, Ort (Setting) und historischer Ort sowie Originalzitat (Text am Bild) an. Darüber hinaus werden auch Filteroptionen zur Verfügung gestellt, die nähere Bestimmungen einiger dieser vorhergehenden Kategorien darstellen. So kann z.B. bei Materiellen Objekten auch nach Farbe, Form oder Material derselben gefiltert werden, bei Personen nach Geschlecht und Stand, usw. Insgesamt bieten wir hier aktuell 30 verschiedene Filtermöglichkeiten zur Auswahl an. Ein weiterer Suchfilter-Typ macht alle in REALonline verwendeten Thesauri durchsuchbar. Über eine Baumstruktur zum Aufklappen können sich damit vor allem jene user behelfen, die einen allgemeineren Suchbegriff verwenden möchten (z.B. „Sitzmöbel“) oder die beispielsweise nicht wissen, dass ein Überschuh im Mittelalter als Trippe bezeichnet wird, und sich anhand der Liste zu Fuß- und Handbekleidungen einen Einblick verschaffen. ICONCLASS bietet über das speziell für die ikonographische Bilderschließung entwickelte Codesystem eine gezielte Filtersetzung, die sich gut zum Vergleichen mit anderen Bilddatenbanken eignet, die ebenfalls über ICONCLASS-Notationen abfragbar sind.

Der Geobrowser besteht aus zwei Teilen: Eingeblendet wird eine interaktive Karte mit den Zahlen zu Werken, die nach Regionen geclustert sind. Dazu wurden die geographischen Koordinaten der Standorte eingefügt, an denen sich die Werke heute befinden. Dieser Zugriff eignet sich gut, wenn man nach Bildwerken in einer bestimmten Region sucht oder kulturell interessante Orte besuchen und sich auf die Reise vorbereiten möchte. Unterhalb der Karte sind als hierarchischer und klickbarer Baum einige Felder aus den Metadaten so verschränkt, dass eine Navigation vom Staat über Bundesländer und Standorte hin zu den Institutionen und den dort aufbewahrten Kunstwerken und Artefakten nach Inventarnummer bzw. Signatur möglich ist.

- Abb. 7: Geobrowser in REALonline mit Anzeige eines Standorts in der Kartenansicht.

Die Facettensuche leistet eine interaktive Verfeinerung der Suche und liefert ein Zahlenranking, das sich mit jeder weiteren Auswahl laufend neu errechnet. Die ausgewählten (oder ausgeschlossenen) Begriffe werden in einem Suchkorb zusammengehalten und können jederzeit wieder abgewählt werden. Angezeigt werden jeweils die Top Ten-Ergebnisse; über den Button „Mehr anzeigen“ kann man zur vollständigen Liste navigieren.

- Abb. 8: Screenshot aus der Facettensuche von REALonline, geöffnet ist der Suchfilter-Typ „Werke“.

Es war uns wichtig, im Rahmen der Suche auch zu vermitteln, welche Daten in REALonline vorhanden sind. Die Visualisierung der Datierung als Balkendiagramm und die Verteilung der Standorte als Kartenansicht vermitteln den Nutzer_innen einen Eindruck davon, welche Datensätze aus welchen zeitlichen und geografischen Räumen verfügbar sind. Bei den Einträgen in den Facetten wird neben der Anzahl, wie oft ein Begriff in Bezug auf die aktuellen Einschränkungen vorkommt, auch ausgegeben, wie oft er insgesamt in REALonline vertreten ist. Diese Information dient dazu, das Verhältnis von Suchergebnis und den gesamten Daten zu vermitteln. Man kann sie aber auch zum Navigieren nutzen: ein Klick auf diese Zahl beginnt eine neue Suche mit der Gesamtzahl des Eintrags als gesetztem Filter. Die Facettensuche in REALonline kann also neben dem Verfeinern auch zum Browsen eingesetzt werden; sie soll den Nutzer_innen einfach verständlich vermitteln, welche Filtermöglichkeiten und Verkettungen von Filtern verwendet werden können und so frustrierende Nullergebnisse möglichst verhindern.

Ein kurzes Beispiel für eine Suche soll die Möglichkeiten der Facettensuche illustrieren: Im Suchfilter-Typ „Werke“ kann man im Suchfilter „Institution“ die Österreichische Galerie Belvedere auswählen und man erhält 108 Datensätze als Ergebnis. Interessiert man sich weiters für dargestellte Sitzmöbel, kann man im Thesaurus „Objekte-Tiere-Pflanzen etc.“ diesem Pfad folgen: Materielle Objekte → Möbel → Möbel – Sitzmöbel.

- Abb. 9: Screenshot zur Facettensuche in REALonline, geöffnet ist der Suchfilter-Typ „Beschreibungen“.

Über den Suchfilter-Typ „Beschreibungen“ findet sich in der Kategorie „Person – Gestus/Körperhaltung“ der Eintrag „sitzend“. Wählt man diesen durch das Klicken der rechten Checkbox mit dem Kreuz ab, bleiben nur noch jene 5 Datensätze übrig, auf denen zwar ein Sitzmöbel dargestellt ist, aber keine Person als sitzend erfasst wurde.

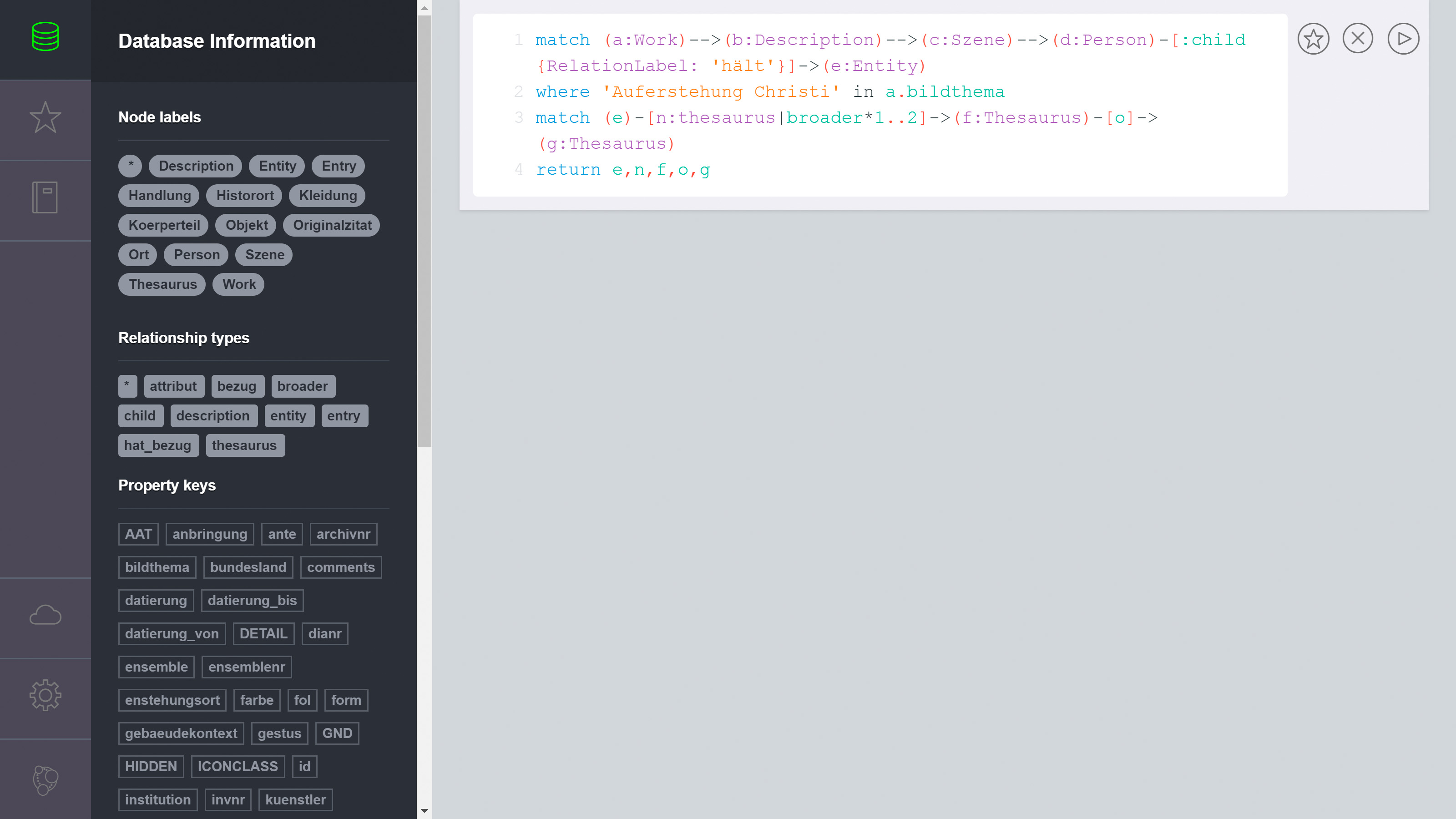

Szenario B: Komplexe Abfragen

Wie das letzte Beispiel gezeigt hat, können bereits mit der Facettensuche von REALonline eine Reihe von kombinierten Abfragen gestellt werden, die auch im Zusammenhang mit einer wissenschaftlichen Nutzung der Bilddatenbank relevant sein können. Die gesetzten Filter beziehen sich dabei immer auf einen gesamten Datensatz. Mit der Auswahl „rot“ in der Facette „Kleidung – Farbe“ und „Schuh“ in „Kleidung“ erhält man Treffer, auf denen mindestens ein Kleidungsstück in roter Farbe dargestellt ist und auf dem mindestens einmal ein Schuh als Kleidung erfasst wurde. Dabei muss es sich aber nicht zwangsläufig um rote Schuhe handeln, es könnten z.B. auch ein roter Hut und schwarze Schuhe auf dem Bild dargestellt sein. Abfragen, die in ihrer Komplexität über die Möglichkeiten der Facettensuche hinausgehen, weil sie mit ganz konkreten Merkmalskombinationen (z.B. Schuhe, die rot sind), mit genau definierten Konfigurationen (z.B. mehr als zwei, aber weniger als fünf dargestellte Personen), mit den Bezügen zwischen Entitäten (z.B. Fische, die auf einem Teller liegen und nicht im Wasser schwimmen) oder mit der Verkettung der vorgenannten Optionen operieren möchten, können über die sogenannte Expert_innen-Suche in REALonline gestellt werden. Wir haben dazu alle erhobenen Informationen (Werke, Beschreibungen, Thesauri etc.) in eine Graph-Datenbank exportiert und somit stehen die Daten in vollem Umfang für die Forschung zur Verfügung. Diese Expert_innen-Suche ermöglicht es den Nutzer_innen, in einem neo4j-Browser einerseits komplexe Abfragen mit der Abfragesprache cypher an die Datenbank zu stellen und andererseits das Ergebnis entweder in Form einer Tabelle oder als Graph zu visualisieren. Damit können die Daten nun auch einfacher und nachvollziehbar in Forschungs- oder Publikationsprojekten verwendet und zitiert werden.

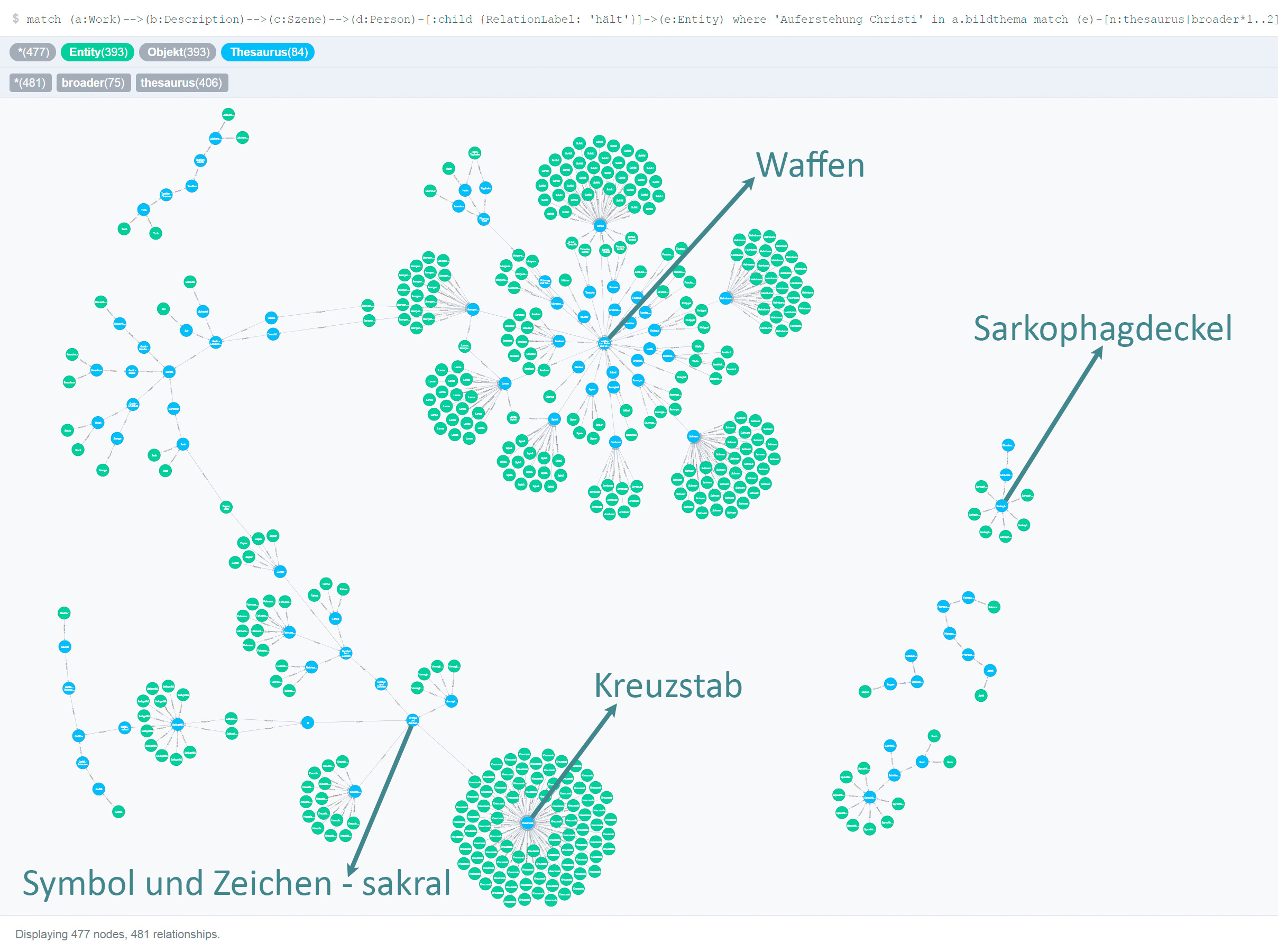

Auch hier möchten wir ein Beispiel anführen, das die Möglichkeiten der Expert_innen-Suche zeigt. In diesem Fall wollten wir wissen, welche Gegenstände von dargestellten Personen in Händen gehalten werden, die bei einer Auferstehung Christi zu sehen sind.

- Abb. 10: Screenshot der Abfrage im neo4j-Browser.

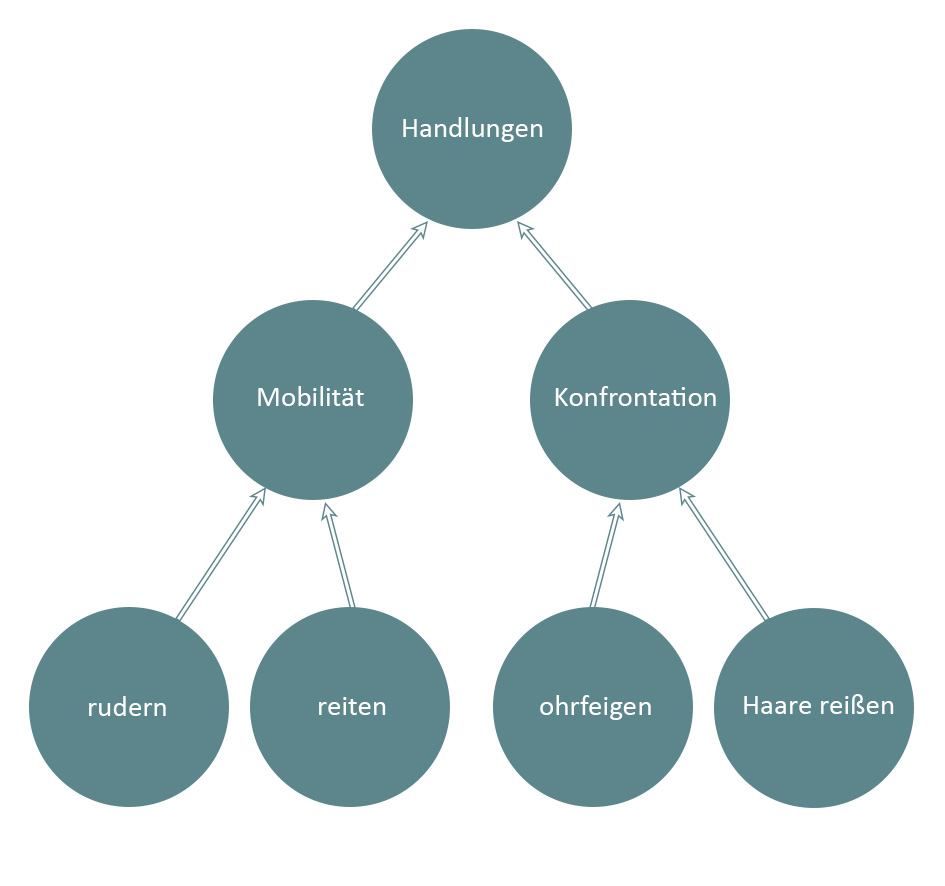

Um besser nachvollziehen zu können, um welche Kategorien von Objekten es sich dabei handelt, sollten auch die übergeordneten Thesaurusbegriffe ausgegeben werden. Die verschiedenen Ebenen des Thesaurus sind im Graph durch aneinandergereihte Knoten repräsentiert.

- Abb. 11: Beispiel der Repräsentation einiger Einträge aus dem Thesaurus ‚Handlungen‘.

Das Ergebnis der Abfrage im neo4j-Browser ist eine Visualisierung der Daten als Graph, wobei die Gegenstände als grüne Knoten wiedergegeben sind und die blauen Knoten für die Einträge aus dem Thesaurus stehen.

- Abb. 12: Screenshot des Ergebnisses als visueller Graph im neo4j-Browser. Die dunkelgrünen Pfeile und Beschriftungen wurden nachträglich hinzugefügt.

Die Anzahl der grünen Knoten zeigt an, wie oft ein bestimmter Thesaurusbegriff verwendet wurde, das heißt, welche Gegenstände wieviele Male auf den insgesamt 165 in REALonline erfassten Datensätzen zur ‚Auferstehung Christi‘ vorkommen. Ablesen kann man daran, welche Elemente in der Bildtradition anhand der Beispiele vom 12. bis ins 16. Jahrhundert gefestigt sind: Das ist ersichtlich an der Häufung von Objekten, die in die Kategorie „Waffen“ oder in die Kategorie „Symbol und Zeichen – sakral“ (wie etwa der Top Treffer „Kreuzstab“) fallen. Nur sechsmal kommt der Begriff „Sarkophagdeckel“ vor. Dabei handelt es sich durchwegs um Kunstwerke, bei denen der Engel gerade im Begriff ist, den Deckel vom Grab wegzuheben.

- Abb. 13: Auferstehung Christi, Tafel eines Flügelaltars, Medias (Rumänien), um 1480/90. REALonline 014772. Foto: © Institut für Realienkunde – Universität Salzburg.

Dieser Befund in REALonline kann als Ausgangspunkt und Ideengeber für weitere Forschungen dienen. So kann man beispielsweise analysieren, ob das in REALonline relativ selten vertretene Motiv vielleicht in anderen Gattungen zahlreicher vertreten ist, die in der Bilddatenbank nicht so oft vorkommen, wie etwa in der Druckgrafik. Man kann ausgehend von dem verwendeten Motiv mittelbare oder unmittelbare Zusammenhänge in den künstlerischen Netzwerken untersuchen oder überlegen, wie die aus dem späten 15. bzw. frühen 16. Jahrhundert stammenden Beispiele mit früheren Werken in Zusammenhang stehen, die ein vergleichbares Motiv zeigen, wie etwa die Auferstehung Christi vom Peter- und Paul-Altar von St. Lamberti in Hildesheim von um 1425. Die Frage, ob diese dargestellte Interaktion des Engels mit dem Objekt vielleicht auch in Zusammenhang mit (den Aufführungspraktiken in) Oster- bzw. Passionsspielen in Zusammenhang stehen könnte, kann ein möglicher Ausgangspunkt für interdisziplinäre Untersuchungen sein.

Weitere Funktionalitäten von REALonline

Neben den Suchfunktionen sind in REALonline auch ein Blog und eine Sammlung der meistgestellten Fragen (FAQ) vorhanden. Zudem kann man im Menüpunkt MyREALonline – Sammlungen eigene Zusammenstellungen von Datensätzen anlegen. Diese Sammlungen können entweder nur für den eigenen Gebrauch bestimmt sein, mit anderen geteilt oder öffentlich zugänglich gemacht werden. In vielen Bilddatenbanken wird registrierten Nutzer_innen angeboten, zu diesen Sammlungen einen (kurzen) Freitext oder Schlagwörter zu speichern. Vor allem im Forschungsprozess ist es aber auch oft hilfreich, sich zu einem einzelnen Datensatz in seiner Sammlung eine Notiz zu machen. Damit die Nutzer_innen dafür nicht ein eigenes Dokument mit Verweisen anlegen müssen, gibt es in REALonline sowohl die Möglichkeit zur gesamten Sammlung Text zu speichern, als auch zu den einzelnen darin enthaltenen Datensätzen. Öffentliche Sammlungen können damit auch den Charakter einer virtuellen Ausstellung annehmen oder als Unterstützung in der Lehre eingesetzt werden.

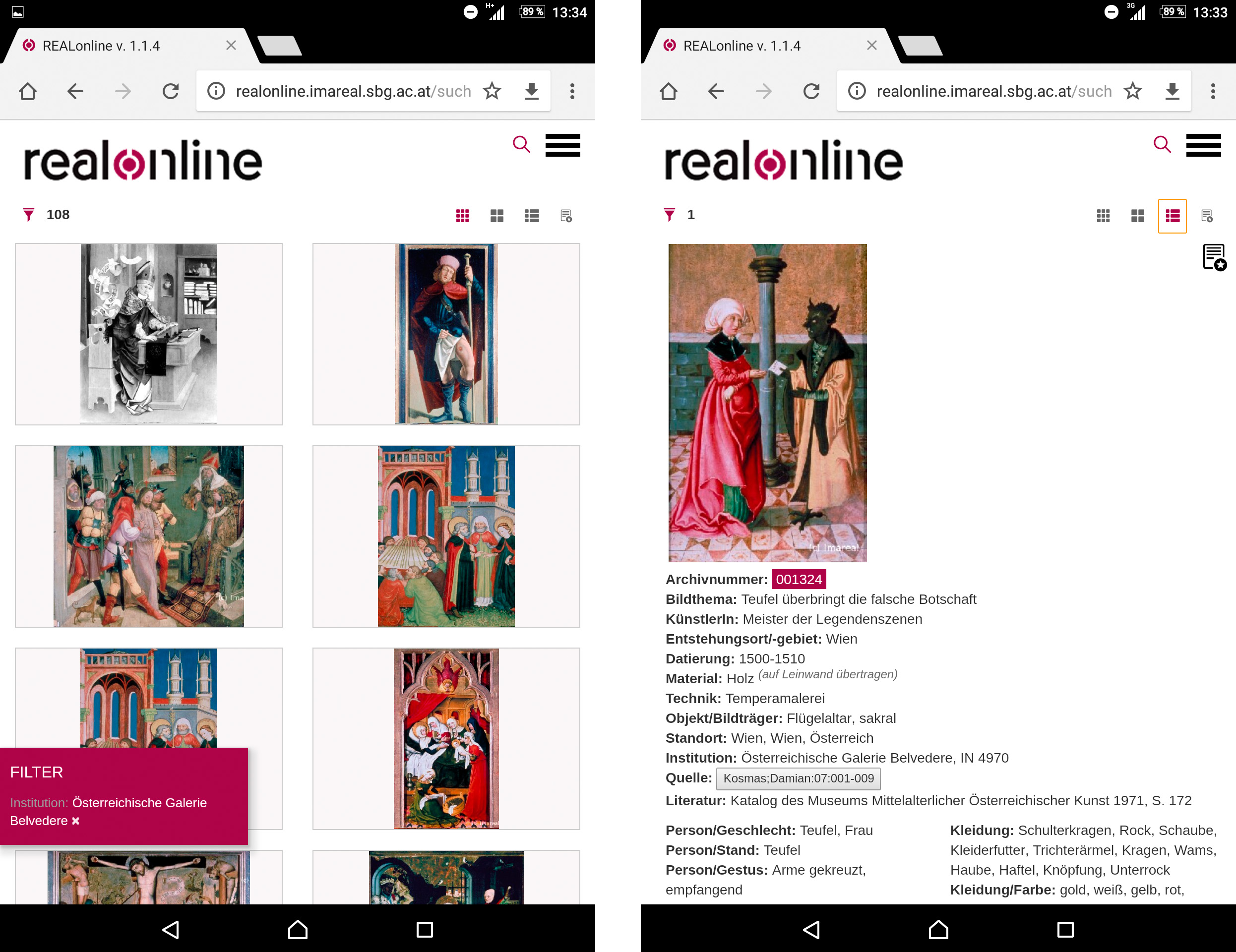

Die Responsive-Version für Smartphones und Tablets

Infolge der rasanten Verbreitung von Smartphones und Tablets erschien es uns wichtig, REALonline auch für Mobilgeräte verwendbar zu machen – um unterwegs zu recherchieren oder sich vielleicht sogar am Standort der Kunstwerke die Daten aus REALonline am Mobilgerät ausgeben zu lassen. Die Entwicklung der „mobilen Version“ stellte uns vor gewisse Herausforderungen. War es schon schwierig, die Vielzahl an verfügbaren Metadaten und Annotationen gemeinsam mit den Bildern auf einem „normalen“ Monitor unterzubringen, so sind die Grenzen auf den Displays von Smartphones noch einmal deutlich enger gesetzt. Bis zu einem gewissen Grad kann die Darstellung der Informationen mithilfe des responsive Webdesigns angepasst werden, die punktgenaue Interaktion über den Touchscreen ist bei einer großen Dichte an Auswahlfeldern sehr schwierig. Aus diesem Grund haben wir für Mobilgeräte eine eigene Version mit einer zwar reduzierten, aber speziell für die mobile Nutzung optimierten Oberfläche entwickelt. Im Unterschied zur Vollversion wurde vorerst noch auf den Geobrowser verzichtet.

Die Ergebnisliste bietet die bekannte Einstellung mit den Vorschaubildern sowie die erweiterte Voransicht mit Informationen aus den Werks- und Beschreibungsdaten. Tippt man auf ein Bild, werden die – im Vergleich zur Vollversion reduzierten – Detailinformationen angezeigt. Der Image-Viewer steht auch in der Mobilversion zur Verfügung, auf die Tagged View, die Graphen- und die Listenansicht sowie auf die Ausgabe der gesamten Textinformationen wurde jedoch verzichtet. Hier empfiehlt es sich, auf die Vollversion umzusteigen.

- Abb. 14: Screenshots der Mobilversion von REALonline – Voransicht der Ergebnisse zur Suche „Österreichische Galerie Belvedere“ (links) und Detailanzeige eines Datensatzes (rechts).

Resümee

In den Digital Humanities sind Forschungen zu dargestellten Elementen auf mittelalterlichen oder frühneuzeitlichen Bildern die Ausnahme. Mit ein Grund dafür ist, dass in den vielen bestehenden Bilddatenbanken von Kulturerbe- und Wissenschaftseinrichtungen solche spezifischen semantischen Daten – abgesehen vom Bildthema – kaum erfasst werden und auch eine computergestützte Erkennung von Bildelementen für diesen Quellenbestand noch nicht weit genug entwickelt ist. Deshalb werden Bilder in den Digital Humanities gegenwärtig überwiegend hinsichtlich sogenannter Low-Level Features wie Farbe, Textur etc. ausgewertet. Muster, Zusammenhänge und Unterschiede auf der Ebene dargestellter Bildelemente in den unterschiedlichen visuellen Medien dieser Zeit aufzuzeigen oder die Bildinhalte adäquat in interdisziplinäre Forschungen einzubringen, um so die spezifischen Diskurse unterschiedlicher Quellengattungen zu vergleichen, ist daher meist mit einem enormen Aufwand seitens der Forscher_innen verbunden.

In REALonline stehen diese Daten für visuelle Medien des Mittelalters und der frühen Neuzeit zur Verfügung. Nach einem Relaunch können Nutzer_innen auf diese wertvollen Daten über verschiedene Suchmöglichkeiten – Facetten-, Volltext- oder Expert_innensuche – noch effizienter zugreifen und ihre Fragen an das Material stellen. Eine Palette an verschiedenen Ansichten und teils interaktiven Visualisierungen steht nun für den Detaildatensatz bereit.

Im Beitrag haben wir die neuen Features des Frontends in groben Zügen beschrieben. Die neue Version von REALonline ist das Ergebnis einer mehrjährigen Zusammenarbeit zwischen Vertreter_innen aus den Geistes- und Kulturwissenschaften, der Softwareentwicklung und dem Informations- und Webdesign. Im Vorfeld der Implementierung jeder einzelnen Funktion, jedes Navigationselementes, der Informationsvisualisierungen usw. mussten Entscheidungen getroffen werden, bei denen die Balance zu finden war zwischen den Positionen der Datenbankprogrammierung, des Webdesigns und den Anforderungen bzw. Erwartungen von Seiten der Geistes- und Kulturwissenschaften. Ziel des Relaunchprojekts war es, für komplexe Daten ein möglichst intuitives User-Interface zu entwickeln, das sowohl von Wissenschaftler_innen als auch am historischen Kulturerbe Interessierten genutzt werden kann. Gleichzeitig wurde in allen Stufen der Datentransformation und bei der Programmarchitektur darauf Bedacht genommen, die Lösungen für zukünftige Erweiterungen offen zu halten.